Est-ce GPT? Pourquoi Détecter un texte généré par IA est un Défi

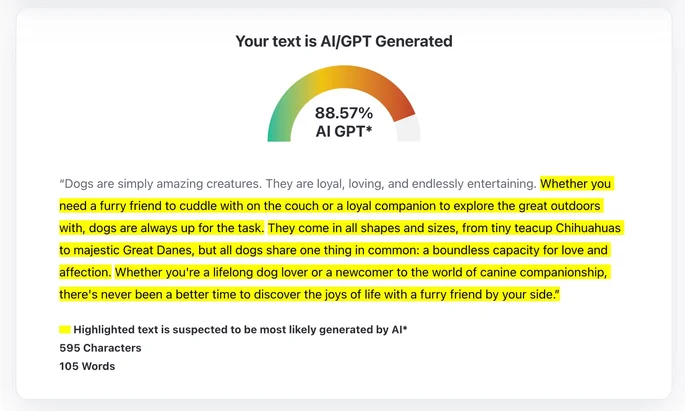

Pouvons-nous détecter qu’un texte à été écrit par une IA ? Bien qu’il existe des outils conçus pour détecter les textes écrits par IA, ils sont souvent inéfficace, notamment avec des modèles sophistiqués comme GPT-4 (source). De nombreux experts dans le domaine ont commencé à rejeter ces outils en les qualifiant d’inutile pour la plupart (source). Même OpenAI, les créateurs de GPT-4, ont abandonné leur propre outil de détection d’IA. Ils ont admis qu’il ne fonctionnait pas (source). Alors, qu’est-ce qui rend si difficile la détection de textes générés par IA ? Et que pouvons-nous faire à ce sujet ? Plongeons dans ces questions.

Pourquoi est-il si difficile de détecter si un texte est écrit par une IA ?

Essentiellement, détecter un texte écrit par une IA nécessite une IA plus avancée. Si une telle IA existe, elle serait probablement également utilisée pour la génération de texte. De plus, des outils comme Quillbot ou Wordtune peuvent affiner le contenu généré par IA pour le rendre presque indiscernable de l’écriture humaine (source). Ainsi, nous avons atteint un point dans une course aux armements où les générateurs de textes sortent gagnant.

Le seul scénario où une IA pourrait identifier de manière fiable un texte écrit par un humain est lorsqu’il contient des erreurs d’orthographe évidentes ou des particularités stylistiques uniques; cela dis, une IA peu simuler également ces traits. D’autre part, des textes très précis et formels peuvent être identifiés à tort comme générés par IA. Par conséquent, les outils de détection d’IA peuvent produire un grand nombre de faux positifs et de faux négatifs dans leurs diagnostics. Difficile donc de leurs faire confiance.

Vous pourriez penser qu’une IA avancée comme GPT-4 pourrait facilement repérer un texte écrit par son prédécesseur, GPT-3.5. Cela est probablement vrai. Cependant, comment pouvez-vous être sûr qu’un texte a été écrit par GPT-3.5 ? Bien sûr, si vous le saviez, vous pourriez avoir plus confiance dans le résultat du test. Mais si vous le saviez, vous ne testeriez pas. Ainsi, vous ne savez pas et vous ne pouvez pas faire confiance aux résultats du test. C’est un problème impossible. Alors, y a-t-il un moyen de détecter un texte généré par IA ? Non, nous ne pouvons pas pour l’instant, mais nous avons des idées.

Solutions Légales pour la detection de l’IA

Sous l’Article 52 de la loi sur l’IA fraichement voté dans le parlement européen :

Le système d’IA, le fournisseur ou l’utilisateur doit informer toute personne exposée au système de manière opportune et claire lorsqu’elle interagit avec un système d’IA, sauf si cela est évident dans le contexte de l’intelligence artificielle.

artificial intelligence act

En d’autres termes, une fois que la loi sur l’IA sera implémentée en Europe, tout mails, messages ou autre documents écrit par une IA devra informer l’utilisateur de ce fait. La Chine, les États-Unis et le G7 travaillent également à l’identification des contenus générés par l’IA.

Cela aidera sûrement beaucoup, mais il y aura toujours des mauvais acteurs. Si nous ne pouvons pas prouver qu’un texte est écrit par une IA par des tests, nous ne pouvons pas exercer de pression légale si ce n’est pas mentionné. Oui, bien que cette loi soit une bonne idée, en pratique, elle est difficile à appliquer. De plus, bien que l’article 52 changera sûrement le comportement des entreprises, les individus peuvent ne pas suivre de telles instructions. Oui, je pense à cet étudiant en master qui rédige sa thèse entièrement avec GPT, mais d’autres situations peuvent également s’appliquer.

Solutions techniques pour la detection de l’IA

Une fois de plus, la technologie pourrait tous nous sauver. Dans un article récent, des chercheurs de l’Université du Maryland ont défini une méthode pour « marquer » les textes générés par IA. Le marquage consiste à transformer une sortie en ajoutant un élément indélébile prouvant sa source. Il est généralement utilisé pour la protection des droits d’auteur, mais dans ce cas, il est utilisé pour aider les détecteurs d’IA.

Comment pouvons-nous marquer un texte ? L’article propose de définir une liste aléatoire de mots « secret ». Ensuite, lors de la génération de texte, vous pouvez forcer le modèle à utiliser ces mots plus fréquemment qu’il ne le ferait normalement. Il devient alors évident si un texte a été écrit par une IA.

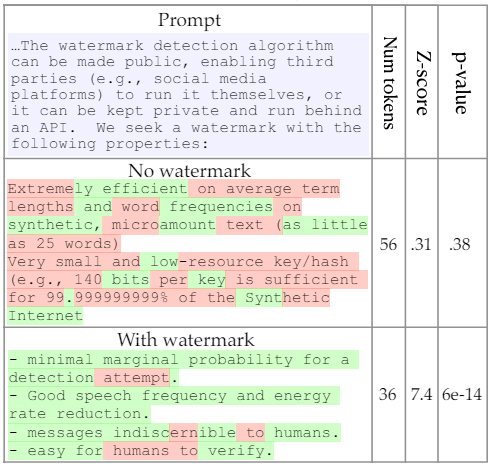

La figure ci-dessous montre deux textes générés par IA, l’un sans marquage et l’autre avec. Nous observons que le modèle sans marquage a une valeur p de 0,38. Cela signifie que le détecteur d’IA pense qu’il y a 38 % de chances que ce texte ne soit pas écrit par une IA. Avec marquage (plus de mots verts), la valeur p est pratiquement de 0. Dans ce cas, le détecteur d’IA est certain que le texte est de l’IA.

Le problème avec cette solution est que quiconque connaît ces mots secret pourrait les remplacer. Ainsi, en pratique, nous pourrions imaginer une solution plus dynamique. Par exemple, cette liste de mots secret pourrait changer après chaque mot généré. Une telle technique pourrait être développée selon une norme fiable. Ensuite, les grands modèles d’IA pourraient être contraints d’utiliser ce type de marquage à l’avenir.

Conclusion

En conclusion, non, nous ne pouvons pas détecter si un texte à été écrit par une IA. Du moins, pas de manière assez fiable pour appliquer des lois ou punir des étudiants paresseux utilisant l’IA pour rédiger entièrement leur mémoire de master. Néanmoins, nous pourrions développer des techniques pour marquer les textes écrits par IA et rédiger des lois pour enforcer leur utilisation. Tel que cela se présente actuellement, cela semble être la solution la plus simple.