Au cours des dernières années, le monde de l’intelligence artificielle a connu une révolution démocratique ; tout le monde en entend parler. Cela est largement dû à une architecture révolutionnaire connue sous le nom de Transformers. Cette avancée a permis aux machines de comprendre et de générer du langage humain de manière auparavant inimaginable. Dans cet article, je vais décrire les avancées technologiques qui on permis un tel changement.

GPT, c’est quoi?

Imaginez avoir une conversation avec une machine capable de prédire ce que vous allez dire. C’est basiquement ce que fait GPT- un modèle de langage conçu pour prédire le prochain mot dans une séquence. En réalité, c’est tout ce qu’il fait et rien de plus. Il examine les mots, les phrases et les paragraphes passés, puis décide quels mots produire un par un. Pourtant, il est capable de produire des réponses extrêmement précises à la plupart des questions que vous lui posez. Son intelligence provient de l’analyse de vastes quantités de données textuelles et de la compréhension des nuances de la langue. En gros, il a lu l’intégralité de l’internet et à accumulé toute la connaissance humaine.

Et les Transformers dans tout ca?

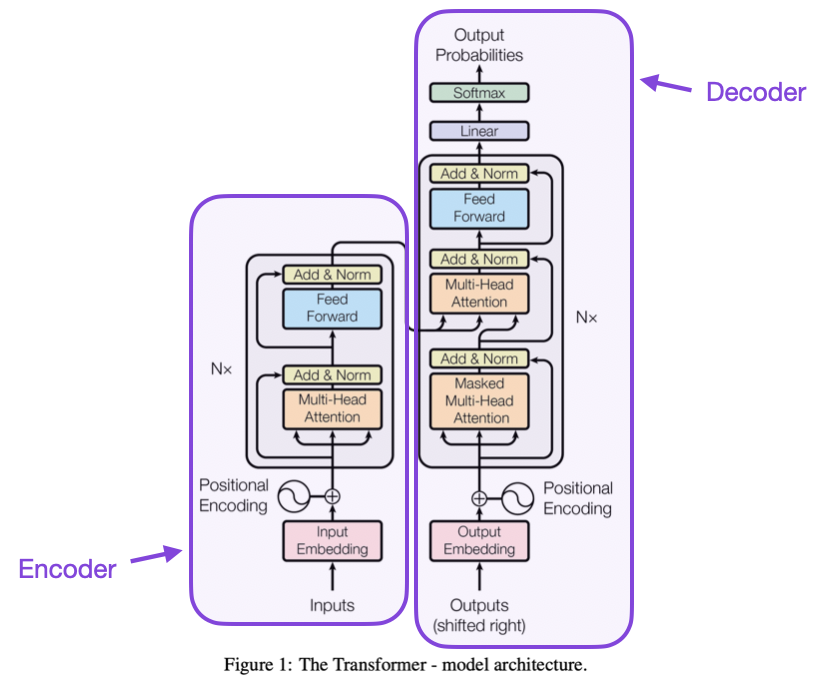

Le Transformer est le cerveau derrière GPT (Generative Pre-trained Transformer). C’est une architecture neuronal conçue pour les tâches de traitement du langage naturel (NLP). Contrairement à ses prédécesseurs, elle excelle dans le traitement de séquences de texte, telles que la traduction de langues, la résumé d’articles ou la génération de réponses semblables à celles d’un humain.

Au cœur de son fonctionnement, un Transformer prend une séquence de mots en entrée (comme une phrase ou un paragraphe) et la transforme en une nouvelle séquence de mots. Ce processus de transformation implique de comprendre le contexte de chaque mot, sa relation avec les autres mots, et l’intention globale du texte. Par exemple, imaginons la traduction d’une phrase de l’anglais vers le français. Le Transformer ne se contente pas de traduire mot à mot. Il considère le contexte complet de la phrase pour choisir les mots les plus appropriés en français. De même, quand il résume un texte, le Transformer identifie les points clés et les thèmes d’un paragraphe et les reformule de manière concise. La capacité du Transformer à générer un texte cohérent et contextuellement pertinent en fait un outil inestimable dans la création de chatbots, la génération de contenu créatif, et même l’assistance à la rédaction de code. C’est comme avoir un linguiste et un écrivain hautement qualifié capables de saisir rapidement le sens des textes et de les traduire ou les résumer avec précision en quelques secondes.

Pourquoi est-ce révolutionnaire ?

Les Transformers ont révolutionné l’IA en introduisant une série d’innovations qui répondent aux limitations critiques des méthodes des modèles précédents. Examinons en détail quoi et pourquoi.

Surmonter le problem de la Dépendance à Long Terme

A mesure que la distance entre les mots augmente, il était de plus en plus difficile pour les modèles précédents de maintenir la connexion entre eux. Cela est dû à la nature séquentielle de leur traitement, qui limite leur capacité à se souvenir du contexte sur de longues séquences. Les Transformers ne lisent pas les mots de gauche à droite mais prennent un texte entier à la fois. Ils découvre les interactions entre chaque mot peut importe la distance. Cela signifie que dans une phrase complexe, le Transformer peut facilement faire le lien entre un mot au début d’un paragraphe à un autre mot bien plus loin dans le texte. Cela assure une compréhension profonde du contexte et des nuances de la langue.

Capacités de Traitement Parallèle

Cette capacité à lire un pan de texte à la fois et non séquentiellement signifie que les transformers sont beaucoup plus rapides que les modèles précédents. En effet, en prenant toute une entrée à la fois, la plupart de leurs calculs peuvent être effectués en parallèle. Cela résulte en une augmentation dramatique de la vitesse de d’entrainement. Cela rend possible l’entrainement de modèles sur d’immenses jeux de données dans un délai raisonnable. Cette capacité à s’entraîner sur de plus grands jeux de données, à son tour, améliore significativement la performance du modèle, car il peut apprendre à partir d’un ensemble plus étendu et varié de motifs et structures linguistiques.

Préformation et Adaptabilité à Plusieurs Tâches

Une pierre angulaire de l’impact révolutionnaire des Transformers est leur capacité à être utilisés pré-entrainés. Des modèles comme GPT sont initialement formés sur un énorme corpus de données textuelles. Ainsi, ils sont capables d’apprendre une large gamme de motifs, de structures linguistiques et de connaissances. Cette phase de préformation permet au modèle de développer une compréhension profonde de la langue. Cela peut ensuite être sollicité ( par un prompt ) pour effectuer une grande variété de tâches.

Le processus de pré-entrainement permet la création de modèles extrêmement grands et coûteux en termes de calcul, car ce coût est encouru une seule fois. Après le pré-entrainement, ces modèles peuvent être réutilisés et adaptés pour de nombreuses tâches avec un coût minimal. Cela rend les capacités avancées de NLP accessibles pour une large gamme d’applications, même pour ceux sans les ressources pour former de grands modèles à partir de zéro.

Pour référence, GPT-4 est estimé avoir requis 62 GWh d’énergie pour sa formation, ou l’équivalent de la consommation énergétique de 15 000 maisons européennes en un an. OpenAI a encouru un coût d’environ 2 milliards de dollars pour former le modèle sur plus de 10 trillions de mots, soit environ 10 millions de livres. Il a nécessité plus de 25 000 GPU et des dizaines de jours pour sa creation. Et pourtant, vous pouvez utiliser GPT chez vous et il répondra rapidement en quelques secondes et nécessitera peu d’énergie pour générer votre réponse (plus ou moins 300 Wh).

Conclusion

L’architecture des Transformers a révolutionné le domaine de l’intelligence artificielle. Cette innovation a permis aux machines d’interpréter, de comprendre et de générer le langage humain avec une précision et une rapidité sans précédent. En surmontant les défis de la dépendance à long terme et en permettant le traitement parallèle, les Transformers ont considérablement amélioré l’efficacité et l’efficacité des modèles de langage comme GPT. Le processus de pré-entraînement, qui implique l’apprentissage à partir d’un vaste corpus de données textuelles, a permis à ces modèles d’exécuter un large éventail de tâches de NLP avec peu de ressource de calcul. En conséquence, les modèles de NLP sont désormais accessibles à un public plus large.