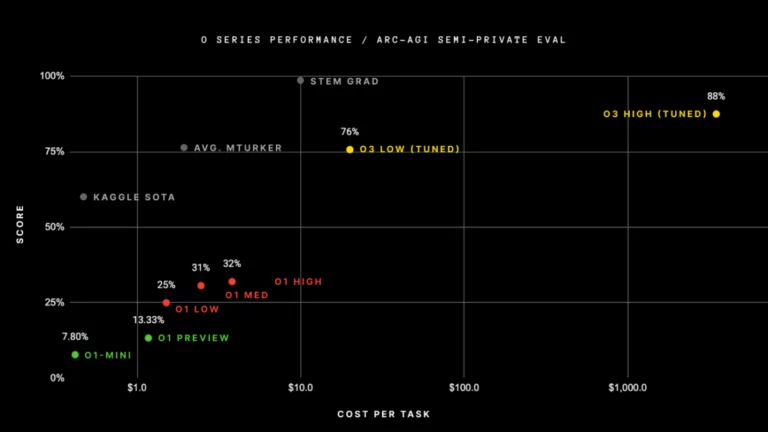

Avec la sortie du modèle o3 d’OpenAI, le débat autour de l’Intelligence Artificielle Générale (AGI) s’est récemment intensifié, certains se demandant même : « o3 est-il une AGI ? ». En effet, o3 d’OpenAI a atteint des performances inédites sur des benchmarks tels que l’ARC-AGI, avec un score de 87,5 %, dépassant le seuil humain fixé à 85 %. De tels résultats ont conduit beaucoup à suggérer que l’AGI est déjà là, ou du moins très proche.

Ne vous méprenez pas, cette technologie est impressionnante, et je l’ai moi-même utilisée pour m’aider à rédiger cet article. Mais O3 est-il vraiment une AGI ? Sommes-nous proches de l’AGI ? Non, je pense que nous en sommes encore loin. Au cœur de ce débat se trouve l’absence d’une définition claire de ce qu’est réellement l’AGI. L’objectif de cet article est donc de définir l’AGI en précisant les caractéristiques qu’elle devrait posséder.

Le modèle o3 d’OpenAI : Pourquoi a-t-il déclenché le débat sur l’AGI ?

Le modèle o3 d’OpenAI : Des résultats impressionnants sur les benchmarks d’AGI

Le modèle o3 d’OpenAI a démontré des capacités remarquables, excellant dans des tâches complexes de codage et la résolution de problèmes mathématiques avancés. Notamment, il a enregistré une amélioration de 22,8 % par rapport à son prédécesseur o1 sur le benchmark de codage SWE-Bench Verified (Wired). De plus, le modèle o3 d’OpenAI a presque réussi l’édition 2024 de l’American Invitational Mathematics Examination (AIME), ne faisant qu’une seule erreur. Il a également obtenu un score de 87,7 % sur un benchmark destiné à évaluer des compétences scientifiques de niveau expert (The Verge).

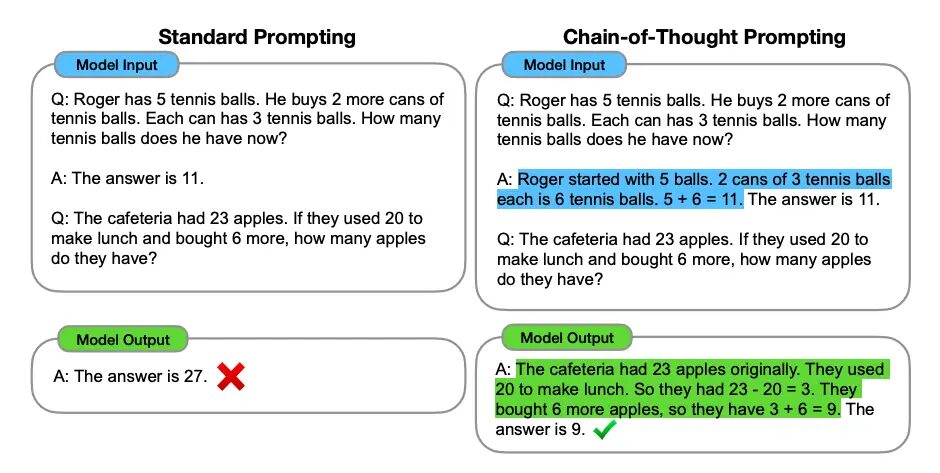

Pour atteindre ce niveau de performance, le modèle o3 d’OpenAI utilise et est entraîné avec la méthode « Chain of Thoughts » (chaîne de pensées). En résumé, cela revient à faire réfléchir le modèle « à voix haute » avant qu’il ne commence à fournir une réponse. Cela entraîne des améliorations significatives des performances, mais cela s’avère aussi extrêmement coûteux en termes de calcul et d’énergie. Par conséquent, bien que ces modèles soient puissants, ils sont également très inefficaces. Cela indique que, bien que cette solution soit impressionnante, elle pourrait difficilement être généralisée pour résoudre des problèmes de manière plus étendue.

Certains observateurs interprètent ces performances comme une preuve que le modèle o3 a atteint l’Intelligence Artificielle Générale (AGI). De nombreux employés d’OpenAI ont également déclaré publiquement que « o3 est une AGI » (source, source). Pourtant, de nombreux chercheurs en IA appellent à la prudence. Bien que le modèle o3 soit impressionnant, il reste un produit issu d’un traitement massif de données et d’architectures spécialisées. Cela est encore loin du raisonnement, de la créativité ou de la conscience humaine.

Bien que ces modèles excellent sur des benchmarks connus, ils échouent face à des situations réelles et inconnues. De plus, il existe un phénomène appelé « saturation des benchmarks ». Cela se produit lorsque les modèles d’IA obtiennent des scores quasi parfaits sur des benchmarks existants, rendant ces tests moins efficaces pour mesurer l’intelligence réelle (HAI Stanford). Par conséquent, nous avons besoin de benchmarks plus complexes et exhaustifs pour évaluer précisément les capacités des modèles d’IA.

Le modèle o3 est impressionnant, mais les benchmarks d’AGI ne le sont pas

On pourrait soutenir que les benchmarks traditionnels ne sont pas adaptés pour tester une véritable Intelligence Artificielle Générale (AGI). L’AGI pourrait nécessiter le développement de jeux de problèmes plus complexes pour démontrer ses capacités. Ces problèmes devraient être incomplets, comporter plusieurs étapes, ne pas avoir une seule solution et nécessiter des essais et erreurs itératifs. Le développement logiciel de bout en bout serait un bon exemple. Une IA capable de déboguer, lire de la documentation, gérer des erreurs de dépendances, créer et appliquer des tests unitaires de manière autonome et plus encore, se rapprocherait davantage de l’AGI. Le modèle o3 d’OpenAI ne possède clairement pas ces capacités.

Le modèle o3, malgré ses résultats impressionnants, reste au final un LLM (Large Language Model), conçu pour générer du texte. Ces modèles, aussi impressionnants soient-ils, sont des perroquets stochastiques : ils produisent la réponse la plus probable en fonction d’une requête donnée. Entraînez-le sur des données obsolètes, et il générera des informations scientifiques incorrectes si celles-ci ont été récemment mises à jour. Il ne réfléchit pas, même s’il utilise des chaînes de pensée. Il ne peut pas être créatif et inventer quelque chose qu’il n’a jamais rencontré auparavant. Quiconque utilise ces modèles pour générer de nouvelles idées sait bien quelles sont leurs limites.

AGI et l’argument de la chambre chinoise

Oui, nous avons passé le test de Turing, mais n’oublions pas l’argument de la chambre chinoise. Proposé par le philosophe John Searle, cet argument soulève des questions fondamentales sur la possibilité qu’un traitement purement syntaxique puisse réellement conduire à une compréhension authentique. Cette expérience de pensée suggère que, même si une machine semble « comprendre », elle peut en réalité ne pas avoir conscience du sens, des intentions ou du contexte.

Bien que les modèles avancés comme les LLMs (Large Language Models) excellent à générer des réponses sémantiquement pertinentes, ils le font via l’inférence statistique et la reconnaissance de motifs. Ils ne possèdent pas une véritable compréhension du monde. Ils se contentent de réagir à une requête et de générer la réponse la plus probable.

Qu’est-ce que l’Intelligence Artificielle Générale (AGI) ?

L’Intelligence Artificielle Générale (AGI) est le Saint Graal de l’IA. Elle désigne un système hypothétique capable d’exécuter des tâches intellectuelles à un niveau comparable à celui de l’intelligence humaine. Une AGI démontrerait une compréhension polyvalente, une capacité d’apprentissage et une application des connaissances dans des domaines divers. En somme, tout ce qu’un humain peut accomplir à l’aide d’un ordinateur, une AGI devrait pouvoir le reproduire.

Par exemple, qu’il s’agisse d’analyser des ensembles de données complexes, de programmer ou de résoudre des problèmes créatifs, l’AGI viserait à accomplir toutes ces tâches avec une compétence équivalente à celle d’un humain.

Cognition et créativité : les LLMs ne pensent pas comme nous

Les systèmes actuels, comme le modèle o3 d’OpenAI, excellent sur des benchmarks prédéfinis, génèrent des réponses cohérentes et imitent une certaine créativité. Bien que ces réalisations soient impressionnantes, elles restent superficielles par rapport à l’objectif de l’AGI. Les modèles d’IA créent de l’art, du code et du texte qui semblent originaux, mais leur « créativité » n’est qu’une recombinaison sophistiquée de motifs connus. Ils ne peuvent pas imaginer ou inventer sans se référer à leurs données d’entraînement. Par exemple, sans avoir été exposée aux œuvres de Picasso, une IA ne pourrait jamais imiter son style de manière autonome.

Une véritable Intelligence Artificielle Générale (AGI) ferait preuve de créativité humaine, en générant des concepts inédits et en s’adaptant à des domaines inconnus. Imaginez une AGI capable de résoudre des problèmes en s’appuyant sur des connaissances inter-disciplinaires — combinant des éléments de biologie, de philosophie ou de raisonnement abstrait. Contrairement aux modèles actuels, l’AGI n’imiterait pas, elle innoverait véritablement. Ce saut qualitatif nécessite de dépasser les capacités actuelles de l’IA à traiter des données et à reproduire des schémas, pour atteindre un stade où le raisonnement et la créativité émergent.

La créativité humaine repose sur la curiosité, l’exploration et l’imprévisibilité — des qualités absentes chez l’IA, qui fonctionne selon des contraintes logiques et des règles prédéfinies. Pour reproduire cela, l’AGI devra s’engager dans des expérimentations, des tests itératifs et une pensée imaginative, semblable à la résolution humaine de problèmes par essai et erreur. Cela est bien plus complexe que l’application de méthodes apprises à des problèmes structurés, ce qui représente la limite des systèmes actuels.

Atteindre un tel changement de paradigme nécessite de redéfinir les benchmarks. Les benchmarks actuels sont des ensembles fermés de tâches bien définies, qui ne représentent pas les problèmes réels du monde. L’AGI doit être évaluée sur des benchmarks simulant des problèmes ouverts, mal définis et inspirés de la réalité. Ces scénarios pourraient inclure des définitions ambiguës des problèmes, des outils incompatibles et des processus de raffinement itératifs. La réussite sur ces benchmarks exigerait une IA capable de pensée critique, de redéfinir l’étendue du problème et de le résoudre de manière créative. Une véritable AGI doit refléter l’adaptabilité humaine, comblant le fossé entre les tâches structurées et les exigences imprévisibles du monde réel.

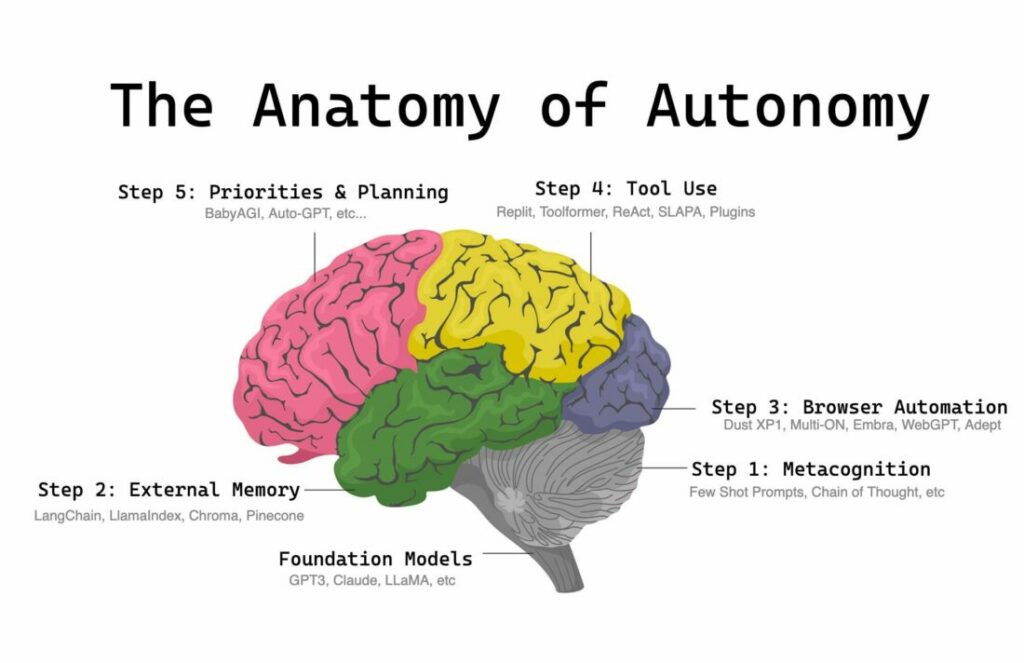

Autonomie et conscience de soi : Nous avons besoin de véritables agents IA

Les systèmes d’IA actuels sont des outils très efficaces, conçus pour suivre des instructions, exécuter des tâches prédéfinies et parfois présenter des comportements émergents surprenants. Cependant, l’autonomie — la capacité de fixer indépendamment des objectifs, d’explorer de nouvelles stratégies ou de décider de manière proactive d’acquérir de nouvelles compétences — reste encore hors de portée. Les modèles comme le modèle o3 d’OpenAI peuvent utiliser des outils de manière experte lorsqu’ils y sont invités. Cependant, ils manquent de l’initiative nécessaire pour apprendre de nouveaux outils de façon autonome ou optimiser leurs processus d’apprentissage internes sans intervention humaine directe.

Une véritable Intelligence Artificielle Générale (AGI) nécessiterait un type d’autonomie fondamentalement différent. Elle devrait être capable d’évaluer elle-même ses performances, d’identifier ses lacunes et d’apprendre de manière autonome. Cela implique un apprentissage autodirigé — choisir quoi apprendre, pourquoi l’apprendre et fixer des priorités indépendantes. Une AGI aurait également besoin d’une forme de conscience fonctionnelle de ses actions, de leurs résultats et de la manière dont elles s’alignent avec des objectifs globaux. Les systèmes actuels sont d’excellents assistants, mais ils manquent de l’adaptabilité autonome et de l’introspection nécessaires pour constituer une intelligence véritable.

Dimensions sociales et morales : L’IA doit être capable de nous solliciter

Si l’Intelligence Artificielle Générale (AGI) devient une réalité, elle devra fonctionner dans le contexte de la société humaine. Tout comme aucun humain ne résout des problèmes de manière totalement isolée, l’AGI dépendrait des humains (et d’autres IA) autant que les humains dépendent d’elle. Pourtant, l’IA actuelle ne possède pas de théorie de l’esprit, c’est-à-dire la capacité de comprendre que d’autres entités, comme nous, possèdent également des connaissances. Les modèles comme le modèle o3 ne peuvent pas interroger les utilisateurs de manière autonome ni engager des dialogues pour clarifier leurs besoins. Sans cette capacité, ils ne peuvent pas discerner si leurs solutions répondent aux attentes des utilisateurs, encore moins adapter leurs réponses en conséquence. Une véritable AGI devrait être une entité véritablement sociale, participant activement à la résolution collaborative de problèmes. Une AGI authentique devrait être capable de nous solliciter autant que nous la sollicitons.

De plus, l’AGI nécessiterait une compréhension avancée des nuances culturelles, historiques et éthiques. Cela ne consiste pas simplement à éviter des actions nuisibles, mais à comprendre pourquoi certaines actions sont préjudiciables, tout en prenant en compte des contextes sociaux, historiques et culturels qui varient énormément à travers le monde. La moralité et l’éthique ne sont pas universelles ; elles sont façonnées par des perspectives culturelles et individuelles. Une véritable AGI doit naviguer avec discernement dans ces complexités, veillant à ce que ses décisions respectent les valeurs de ses utilisateurs. Bien que les systèmes actuels puissent simuler un raisonnement éthique dans une certaine mesure, ils manquent de la profondeur nécessaire pour gérer des dilemmes ambigus ou culturellement sensibles. Parvenir à une AGI signifie créer un système capable non seulement de résoudre des problèmes, mais aussi de le faire en tant qu’entité collaborative, socialement consciente et moralement responsable.

Et bien plus encore

Ceci n’est en aucun cas une représentation complète de l’Intelligence Artificielle Générale (AGI). Nous maîtrisons les benchmarks et les démonstrations impressionnantes, mais l’AGI ne se résume pas à cela. Il s’agit de réunir la cognition, l’autonomie, la créativité et l’intelligence sociale en un ensemble cohérent. Un ensemble qui reflète véritablement la profondeur et la diversité de l’intelligence humaine. Nous n’en sommes pas là aujourd’hui, mais c’est là que nous devons aller. Et pour cela, nous avons besoin de plus que de meilleurs modèles et de meilleurs benchmarks. Nous avons également besoin d’une vision plus claire de ce qu’est l’AGI et, surtout, de ce que nous voulons qu’elle soit.

Le modèle o3 d’OpenAI n’est pas une AGI, mais nous nous en approchons

Le chemin vers l’Intelligence Artificielle Générale (AGI) témoigne de l’ambition humaine pour l’innovation. Bien que des modèles comme le modèle o3 d’OpenAI illustrent des avancées remarquables dans le domaine de l’IA, le passage à l’AGI nécessite bien plus que cela. Il requiert la création de systèmes capables d’une véritable adaptabilité, d’une autonomie, d’un raisonnement approfondi, d’une conscience sociale et d’une créativité authentique.

Cependant, la quête de l’AGI exige une réflexion collective sur ce que l’AGI signifie réellement. Sans une définition claire et partagée, l’AGI risque de devenir un simple mot à la mode marketing, vide de sens et de direction. Pour construire l’AGI de demain, nous devons d’abord définir la vision de ce que nous voulons qu’elle soit. Ce n’est qu’avec cette clarté que nous pourrons tracer un chemin significatif vers l’avenir.