Le traitement du langage naturel (NLP) est l’étude des langues humaines par le biais de l’intelligence artificielle. Elle vise à comprendre le fonctionnement interne des langues afin d’automatiser les tâches telles que la traduction automatique, la synthèse vocale, la reconnaissance vocale, l’extraction d’opinions, etc.

Cependant, pour effectuer ces tâches, nous devons apprendre aux ordinateurs à bien comprendre les langues humaines. Cela inclut la compréhension de la grammaire, de la syntaxe, du vocabulaire, du contexte, de la structure, des ponctuations, etc. De plus, les mots ont le désavantage d’être composés de lettres. Or, les lettres n’ont pas de sens en soi et les ordinateurs ne peuvent manipuler que des chiffres.

Ainsi, les chercheurs en NLP s’appuient sur les modèles de langage (LM) pour résoudre tous ces problèmes. La modélisation du langage désigne la tâche consistant à prédire des mots manquants en fonction d’un contexte. Par exemple, dans le contexte « Le … miaule », le modèle devrait prédire que « … » est « chat ». En entraînant les LMs sur des millions de documents, ces modèles finnisent par comprendre comment les mots sont liés les uns aux autres. Ce fesant, ces systèmes apprennent également à représenter les mots comme des vecteurs de nombres. De telles représentations peuvent ensuite être utilisées pour manipuler du texte à l’aide d’ordinateurs et résoudre la plupart des tâches NLP.

Les LMs sont donc l’un des sous-domaines les plus étudiés de la NLP, et par conséquent, il existe de nombreux articles scientifiques sur le sujet. Dans cet article, je vais présenter certains de ces articles qui ont attiré mon attention récemment.

Notes de lecture

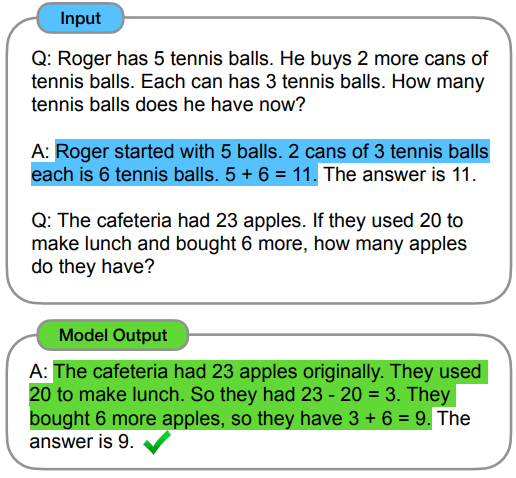

Inciter des chaîne de pensée dans de grands modèles de langage

Cet article présente une méthode pour améliorer le raisonnement logique des modèles de langage. Ils proposent d’entraîner les modèles à produire des chaînes de pensée. Cela signifie que l’on apprend au modèle à fournir un argument logique qui mène à sa réponse au lieu de donner directement ce qu’il pense être la réponse. L’auteur de cet article a montré que le fait de forcer le modèle à fournir un raisonnement pour sa réponse améliore ses performances.

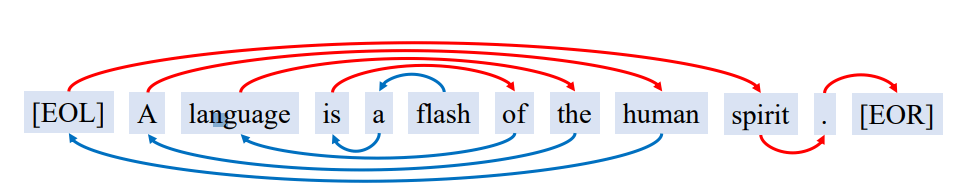

Les techniques traditionnelles de génération de texte utilisant les LMs se basent sur un mot ou une phrase initiale pour générer du texte de gauche à droite ou vice versa. Dans cet article, les auteurs proposent de partir d’un mot initial et de générer du texte autour de celui-ci sans direction spécifique. Ainsi, le texte peut être généré après et avant le mot initial. Cela permet une plus grande flexibilité dans la génération de texte et de meilleures performances dans certaines tâches que les techniques traditionnelles.

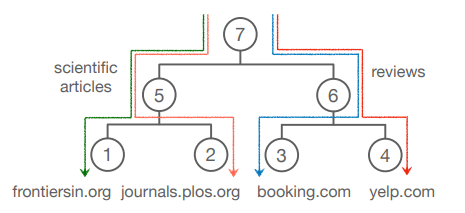

Adaptation hiérarchique efficace au domaine pour les modèles de langage pré-entraînés

Cet article propose un système pour former les LMs afin qu’ils puissent se spécialiser dans plusieurs domaines à la fois. Ils structurent les domaines dans une hiérarchie à l’aide d’un arbre, puis attribuent un adaptateur à chaque nœud. Chaque fois que le LM est utilisé, une séquence d’adaptateurs est appliquée correspondant au chemin vers le nœud du domaine. Chaque adaptateur va modifier le comportement du modèle afin qu’il soit coherent avec le domaine demandé. Ils montrent que cette méthode donne de meilleurs résultats et est également moins coûteuses en termes de calcul car la structure hiérarchique permet le partage des paramètres entre les domaines ancêtres et enfants. De plus, cela aide également les domaines à faibles ressources en les liant à leur domaine ancêtre à ressources plus élevées.

Dans quelle mesure BERT multilingue est-il neutre du point de vue linguistique ?

Dans cet article, l’auteur étudie le modèle multilingue mBERT. Ils montrent que les représentations internes de mBERT peuvent être divisées en composantes spécifiques à la langue et en composantes neutres à la langue. Ceci démontre l’existence d’un point commun mathématique entre toutes les langues humaines étudiées.

Renforcer la cohérence des modèles de langue

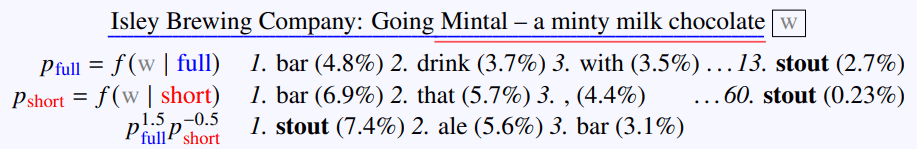

Dans cet article, les auteurs discutent du fait que les modèles de langage (GPT en particulier) ont tendance à accorder trop d’importance au contexte récent. Par conséquent, ces modèles sont moins performants dans les tâches de réponse aux questions (QA) car ils ont tendance à oublier facilement les informations passées. L’auteur a donc proposé une solution d’ensemble utilisant deux modèles de langage, l’un utilisant le contexte entier et l’autre un contexte plus restreint. Nous avons ainsi un modèle qui se focalise sur l’information proche et l’autre sur l’infroamtion lointaine. Afin de produire un resultat, leur solution est pondérée. Cette technique permet d’obtenir de meilleures performances dans les tâches de réponse aux questions

Model compression is a method of producing lighter models by compressing an initially heavy model. Cet article pose la question intéressante de savoir quel type d’impact la compression a sur les LMs en ce qui concerne la robustesse, la généralisation et le biais. Ils étudient deux méthodes de compression populaires : la distillation des connaissances (paradigme professeur/élève) et l’élagage. Ils montrent que les modèles compressés donnent de moins bons résultats sur les ensembles de tests hors distribution tout en donnant des résultats similaires sur l’ensemble de données de même distribution. Par conséquent, les modèles compressés semblent être trop confiants on tendance à moins generaliser en dehors de leurs domaine d’entrainement. Ils sont également plus biaisés. Les auteurs proposent également une méthode pour améliorer la robustesse des modèles compressés.

Attention temporelle pour les modèles de langage

Les modèles de langage apprennent la relation sémantique entre les mots. Cependant, le sens des mots peut changer avec le temps. L’auteur de cet article propose donc d’intégrer la temporalité dans les LMs. Ils ont montré que cela augmente significativement les performances du modèle, notamment pour l’analyse du changement sémantique des mots.

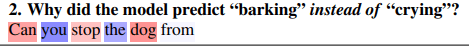

Interpréter les modèles de language avec des explications contrastives

Cet article se concentre sur l’interprétation du raisonnement des LM. Ils proposent d’utiliser des explications contrastives en demandant pourquoi le modèle a choisi X plutôt que Y. En calculant ou le modèle prête son attention, ils peuvent identifier les mots de l’entrée qui ont le plus affecté la sortie. Ainsi, ils ont une vision plus claire du fonctionnement interne d’un LM. Leur approche constitue une façon intéressante d’étudier les LMs.

Les modèles de language ne modelise pas la langue

Cet article affirme que les modèles de langage devraient plutôt être appelés modèles de corpus. En effet, les LM sont entraînés sur un corpus de textes ; par conséquent, leur compréhension du langage est limitée par le corpus sur lequel ils ont été entraînés. Ainsi, les auteurs s’opposent à l’affirmation selon laquelle les modèles de langage modélisent le langage. Selon eux, ils seraient plutôt des perroquets stochastiques incapables de générer des idées innovantes. Cet article s’inscrit dans un débat plus large entre Saussure et Chomsky. L’un pense que le langage peut être réduit à un modèle mathématique, tandis que l’autre estime que le langage est le reflet d’une réalité empirique qui ne peut être réduite à de simples règles mathématiques.